🚀 前言

DeepSeek‑R1 是国产开源推理模型,近年来广受关注,支持复杂推理、编程和数学等任务。相比依赖云端 API 的使用方式,本地部署可实现数据隐私、零延迟、无限次使用和真正免费的体验。

本教程展示如何在本地部署 DeepSeek‑R1,并配合 Ollama 与 Open WebUI 实现完整离线环境部署,无需联网,一句废话都没有。完美契合干练、快速上手的需求,是非常适合技术爱好者和开发者的入门级教学内容 。

📌 一、核心内容概要

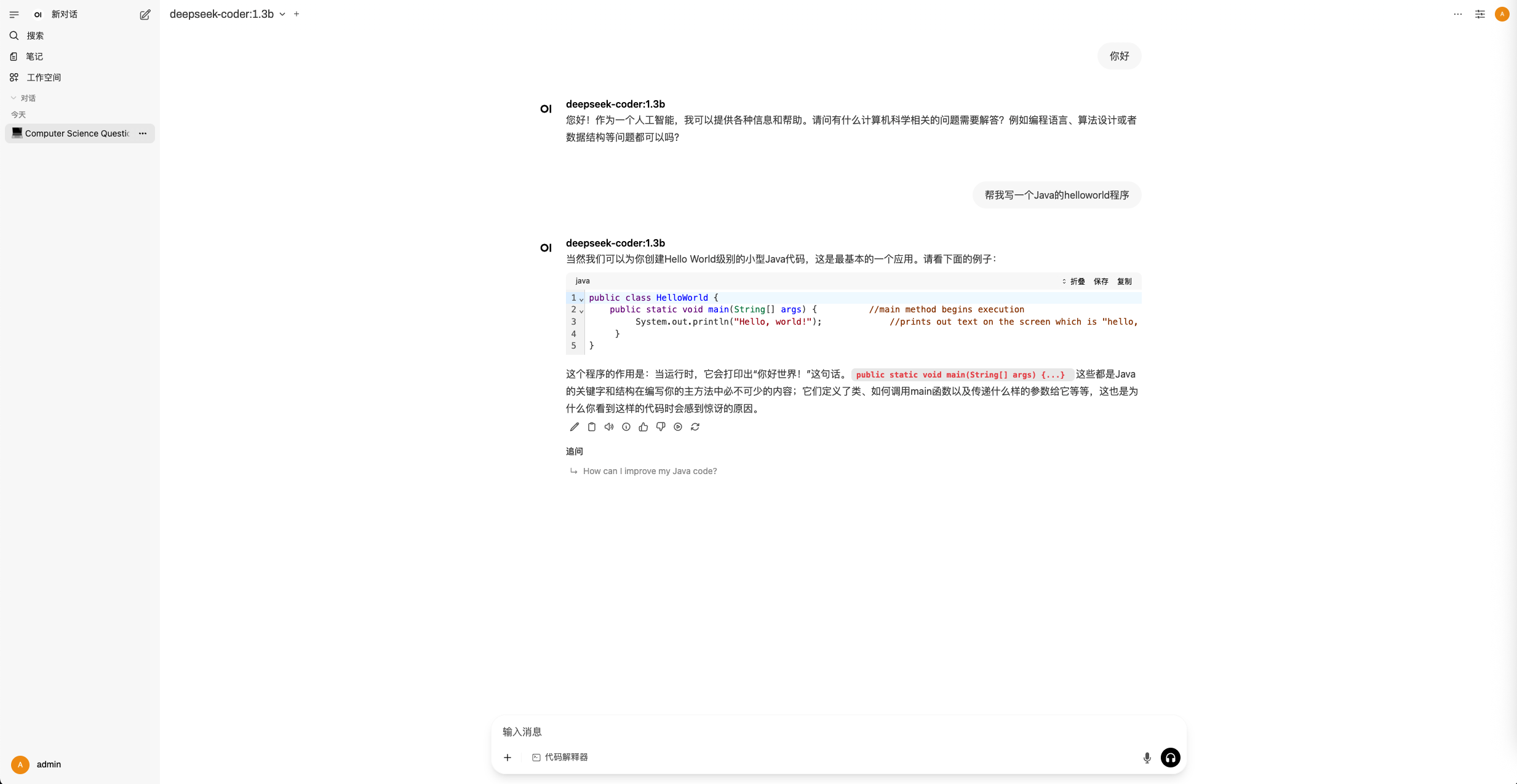

部署效果演示:模型启动后即可响应用户输入。

简洁部署步骤介绍:直击重点,省略冗余。

Docker 安装 Ollama:作为本地模型运行基础框架。

下载 DeepSeek‑R1 模型:支持多种参数量级版本。

安装 Open WebUI:用于图形界面交互模型。

切换 DeepSeek‑R1 版本:根据硬件灵活调整参数规模

🛠️ 二、本地部署步骤详解

✅ Step 1:Docker 安装 Ollama

Ollama 是一个用于本地运行大语言模型的简便工具,自动处理模型下载、量化与推理流程。

version: '3.8'

services:

ollama:

image: ollama/ollama:0.9.5

ports:

- "11434:11434"

volumes:

- ./ollama_data:/root/.ollama

# 有 NVIDIA 且宿主机安装了 NVIDIA Container Toolkit 则可以使用GPU加速

# runtime: nvidia # 核心配置:启用 NVIDIA GPU 支持

# environment:

# - NVIDIA_VISIBLE_DEVICES=all # 可选:明确指定使用所有 GPU

volumes:

ollama_data:安装完成后进入容器可以使用ollama run deepseek-r1 启动模型。

✅ Step 2:下载并启动 DeepSeek‑R1 模型

根据硬件资源选择合适版本:

网址: https://ollama.com/search

docker exec -it ollama /bin/bash # 进入容器

ollama run deepseek-r1:1.5b # 小模型,适合低配设备 ollama run deepseek-r1:8b # 中等性能与资源平衡版本 # 还有 14b、32b、70b 等进阶版本启动后会在本地运行模型并提供交互接口

✅ Step 3:运行 Ollama 服务器(可选)

如果希望持续通过 API 调用模型推理:

ollama serve这样就可以通过 http://localhost:11434/api/chat 接口发送请求,实现自动化或集成调用 。

✅ Step 4:安装 GUI 界面(Open WebUI / Chatbox / Cherry Studio)

Open WebUI(开源界面)/Chatbox/Cherry Studio 均可配置为 Ollama 后端,实现图形化交互体验,例如:

设置 API 地址

http://localhost:11434选择对应模型

deepseek-r1:8b等

version: '3.8'

services:

open-webui:

image: ghcr.io/open-webui/open-webui:v0.6.18

container_name: open-webui

ports:

- "8080:8080" # 主机端口:容器端口

volumes:

- ./webui_data:/app/backend/data # 持久化数据存储

volumes:

webui_data:✅ Step 5:展示效果

🔍 三、本地部署优势对比

通过上面流程,任何具备一定硬件资源的用户(尤其是有 GPU 或高性能 CPU 的开发者),都能快速搭建属于自己的本地 AI 服务系统。

✅ 四、简洁总结

本视频完整覆盖部署流程,从安装 Ollama 到运行模型再到 GUI 使用。

部署迅速(约 5 分钟),适合对时间敏感且注重效率的用户。

推荐设备配置:8 GB 显存支持 8B 模型,24 GB 可上 32B 或 70B 等更大模型。

如果你追求完全离线、安全方便、交互友好又不用开 API,DeepSeek‑R1 本地部署使用 Ollama + Open WebUI 是目前的最佳方案。

评论区