🧠 前言:为什么需要 MCP?

随着大模型(LLM)的快速发展,我们对它们的期待也在不断升级。不再满足于「仅靠语言生成」,而是希望它们能像真实助手一样,调用工具、查资料、发邮件、控制设备。

但问题是:

各大模型厂商(OpenAI、Anthropic、Google)各搞一套「插件」协议

工具接入方式不统一,重复工作量巨大

缺乏跨平台标准,不利于 AI 自动化生态发展

于是,MCP(Model Context Protocol) 应运而生。

🔧 MCP 是什么?一句话解释

MCP 是大模型世界的「USB 接口协议」 —— 为模型调用外部工具、资源与提示词提供统一结构化标准。

MCP 定义了一套简洁而通用的 JSON 协议,让模型可以「清楚理解」它当前有哪些工具可用、能访问什么资源、能套用哪些提示模版。

它不依赖于任何具体厂商,是一种开放协议,任何模型、应用、开发者都可以集成使用。

🧩 MCP 的三种能力模型

MCP 的核心,是将所有可用资源按功能分为三大类:

这种结构化的能力定义使模型在推理过程中能更清晰地组织「调用什么」与「调用方式」。

🧱 MCP 架构核心组件详解:Host、Server 与 Tool

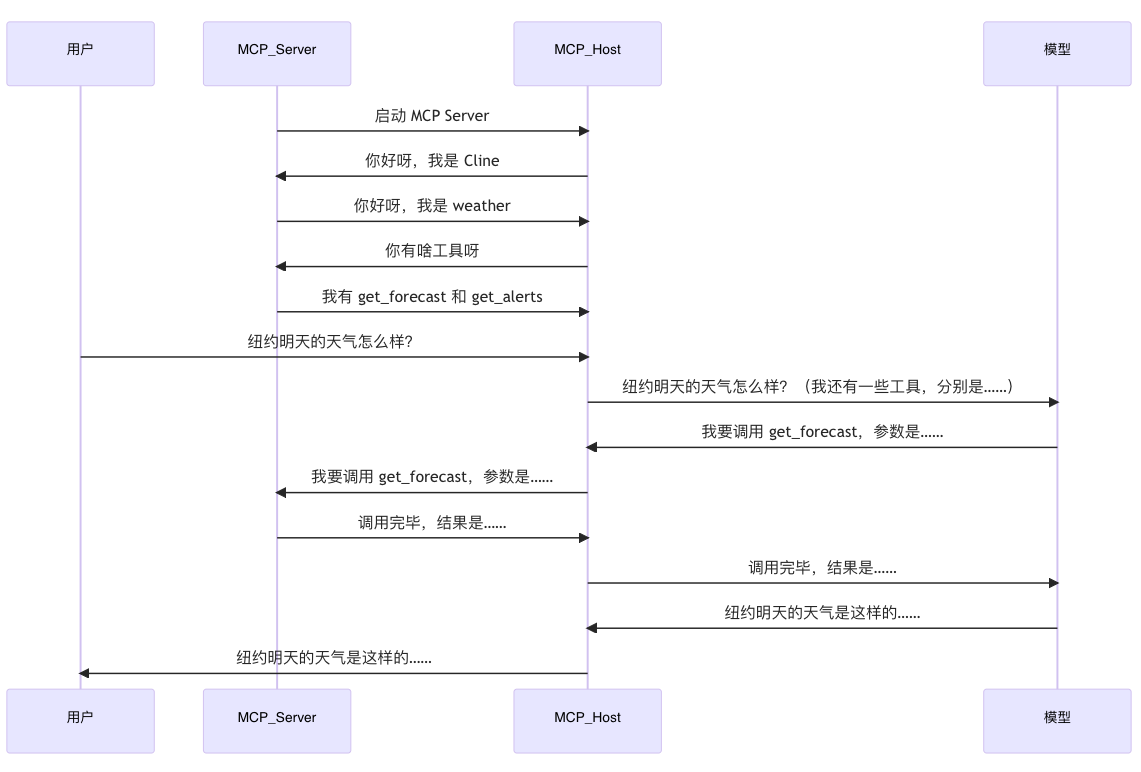

MCP 协议的核心由三个关键角色组成:MCP Host、MCP Server 和 MCP Tool。理解它们之间的关系和职责,是深入掌握 MCP 的基础。

🧠 MCP Host(客户端调用方)

MCP Host 的任务就是:告诉大模型「你有哪些工具可以用」,并把模型的调用请求转发给具体的 MCP Server。

🛠 MCP Server(功能提供方)

MCP Server 是真正的执行者。模型需要调用某个功能时,实际会通过 MCP Host 请求对应的 MCP Server 运行某个 Tool。

🔧 MCP Tool(工具/函数)

每一个 MCP Tool 都定义了:

名称(tool name)

参数结构(schema)

返回值结构(result schema)

可选的 UI 元信息(title、description、icon 等)

你可以理解为「一个带类型约束的 RPC 方法」,但它对模型完全可见。

🔄 它们如何协作?

🎯 MCP 的目标与优势

MCP 本质是一个「能力定义协议」,它为 AI 世界构建了清晰、灵活的工具生态框架。

🌍 谁在使用 MCP?

Anthropic Claude 3 系列:原生支持 MCP 接口,已用于多工具协同能力

OpenAI Agents SDK:正在向 MCP 思路靠拢,探索结构化 API 代理机制

社区项目 uvx、cline、mcp-server-template:开源实践落地,快速集成各种工具能力

💡 MCP 比喻:一台大脑+一堆外设

你可以这样类比 MCP 的整个逻辑:

MCP 的目标是让任何模型,都像一台拥有「神经系统」的智能体,可以连接外设,做复杂任务。

🔮 未来展望:MCP 会成为 AI 世界的 HTTP 吗?

从架构理念、适用范围来看,MCP 很可能在未来:

成为模型世界的统一插件协议

像 REST API 一样成为 AI 系统基础设施的一部分

与云服务、函数平台结合,实现模型即中控(Model as Orchestrator)

🧾 总结

MCP 是为大模型设计的能力调用协议,支持插件、提示词、上下文数据等三大类资源

区分 LLM(模型端)与 Server(工具端)两类角色

提供结构化请求机制,适配任意模型与工具

目标是构建跨模型、跨平台的通用工具生态

评论区